大数据工程师手册 全面系统的掌握必备知识与工具

在当今数据驱动的时代,大数据工程师已成为技术领域的关键角色。他们负责设计、构建和维护能够处理海量数据的基础设施与系统,是连接数据源与商业价值的桥梁。本手册旨在为有志于成为大数据工程师或希望系统提升技能的开发者提供一份全面的指南,涵盖从基础概念到核心工具,再到实战开发的完整知识体系。

一、 大数据基础与核心概念

成为一名合格的大数据工程师,首先需要建立坚实的理论基础。这包括理解大数据的核心特征(4V或5V:Volume体量、Velocity速度、Variety多样性、Veracity准确性、Value价值),以及相关的处理范式。

- 分布式系统原理:大数据处理的基石。需要理解分布式计算、存储、协调和容错的基本原理,如CAP定理、一致性模型、共识算法(如Paxos、Raft)等。

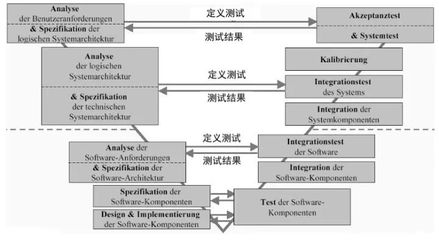

- 数据处理范式:掌握批处理与流处理的区别与联系。批处理适用于对海量历史数据进行离线分析,而流处理则专注于实时或近实时数据的连续处理。理解Lambda架构和Kappa架构等经典设计模式。

二、 核心技能栈与必备工具

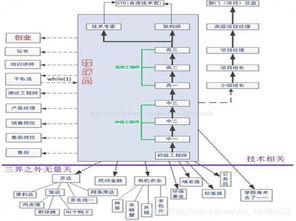

大数据工程师的技能栈可以概括为“一基、三核、多工具”。

- 编程基础(一基):

- Java/Scala/Python:Java是Hadoop生态的基石;Scala是Spark的首选语言,函数式编程特性在处理数据时优势明显;Python则以其简洁和丰富的数据科学库(如Pandas, NumPy)在数据分析、机器学习和快速原型开发中占据重要地位。扎实掌握至少一门是入门的关键。

- 三大核心技术栈(三核):

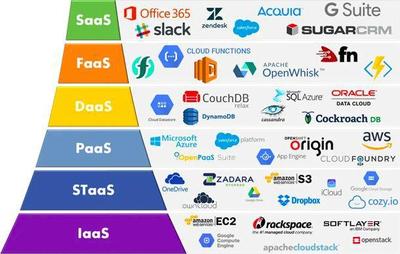

- 存储层:理解分布式文件系统(如HDFS)和NoSQL数据库(如HBase, Cassandra)的原理与应用场景。数据湖(如基于HDFS或云原生对象存储)和数据仓库(如Hive, ClickHouse, Snowflake)的概念与选型也至关重要。

- 计算层:

- 批处理:Apache Spark是当前事实上的标准,需精通其RDD/DataFrame/Dataset API、执行计划优化、内存管理等。经典的MapReduce(Hadoop)原理仍需了解。

- 流处理:Apache Flink以其先进的流计算理念(如事件时间、状态管理)成为主流;Apache Kafka Streams和Spark Streaming也是重要选项。理解流处理的核心概念,如时间窗口、水位线、Exactly-Once语义等。

- 资源管理与调度:YARN是Hadoop生态的传统资源管理器;Kubernetes正成为云原生时代统一编排和部署大数据应用的新标准,需要掌握其基本概念与运维。

- 关键辅助工具(多工具):

- 消息队列/日志收集:Apache Kafka,作为高吞吐的分布式消息系统,是大数据流水线的“中枢神经”,用于解耦数据生产与消费。

- 工作流调度:Apache Airflow或DolphinScheduler,用于编排复杂的数据处理任务依赖关系,实现自动化调度。

- 数据摄取与同步:Sqoop(关系数据库与HDFS之间)、Flume/Canal(日志/增量数据采集)、DataX、Debezium等。

- 集群管理与监控:Ambari, Cloudera Manager(商业版)或自行搭建的Prometheus + Grafana监控体系。

三、 从开发到实战:基础软件开发实践

大数据工程师不仅是工具的运用者,更是系统的构建者。基础软件开发能力是区分高级工程师与普通用户的关键。

- 设计与编码:

- 模块化与可复用性:将数据处理逻辑封装成独立的、可测试的模块或函数。

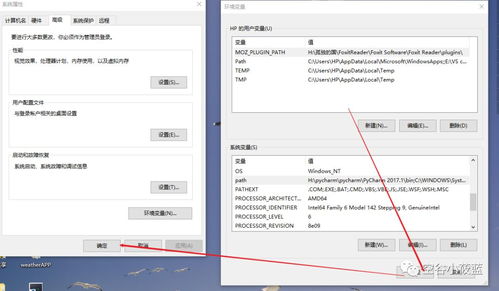

- 配置化驱动:避免硬编码,将环境变量、连接参数、业务规则等抽取为配置文件,提高系统的灵活性和可维护性。

- 代码规范与质量:遵循团队的编程规范,善用单元测试(如JUnit, pytest)和集成测试保证代码质量。理解并使用设计模式解决常见架构问题。

- 性能调优:

- 数据倾斜处理:这是分布式计算中最常见的问题之一,需要掌握使用加盐、双重聚合等策略来应对。

- 资源优化:根据任务特性合理设置Executor数量、内存、CPU核心数等参数。理解并优化Spark的Shuffle过程、存储级别选择。

- SQL与执行计划:对于Hive/Spark SQL,能够阅读和分析执行计划,通过优化SQL写法、建立合适的分区与分桶、使用合适的Join策略来提升性能。

- 数据质量与治理:

- 在数据流水线的关键节点设计数据质量检查规则,如非空校验、唯一性校验、数值范围校验等。

- 实现数据血缘追踪,记录数据的来源、转换过程与去向,便于问题排查和影响分析。

- 关注数据安全与隐私保护,实施数据脱敏、访问控制等策略。

- 部署与运维:

- 容器化:使用Docker将应用及其依赖打包,实现环境一致性。

- CI/CD:建立持续集成/持续部署流水线(如使用Jenkins, GitLab CI),自动化代码检查、测试、构建和部署过程。

- 可观察性:在代码中埋点,记录关键指标和日志,与监控系统联动,实现问题的快速定位与预警。

四、 学习路径与持续成长

大数据技术生态日新月异。建议的学习路径是:先深度,后广度。首先选择一个核心领域(如Spark或Flink)深入钻研,理解其内部原理和最佳实践,构建起处理某类问题(批或流)的完整知识闭环。然后横向扩展,了解生态中的其他组件,并关注云原生(如Kubernetes上的Spark/Flink)、湖仓一体、实时数仓等前沿趋势。

积极参与开源社区,阅读优秀项目的源代码,在实践中不断解决真实场景下的复杂问题,是成长为一名卓越大数据工程师的必经之路。记住,工具和技术会演变,但处理海量数据的核心思想、系统设计能力和扎实的工程实践功底,才是你职业生涯中最宝贵的财富。

如若转载,请注明出处:http://www.xshark-c.com/product/68.html

更新时间:2026-02-24 02:24:32